Paradoxalement, je ne connaissais pas Arvo Pärt, qui en est pourtant une figure emblématique. C'est en m'intéressant aux travaux de l'IRCAM que j'ai découvert le lien évident entre la musique de Pärt et la musique algorithmique. Une sorte de lien entre le minimalisme et l'ambient

Pärt n'utilisait pas d'ordinateur, mais certaines de ses œuvres sont composées avec la rigueur d'un programmeur. Son style Tintinnabuli est un algorithme pur : une série de règles strictes qui, une fois mises en mouvement, génèrent de la musique et engendre des émotions.

Cette découverte a suscité une réflexion : Est-il possible de programmer un générateur de Tintinnabuli qui, grâce à l'aléatoire, pourrait créer une composition entière ?

L'Algorithme comme partition

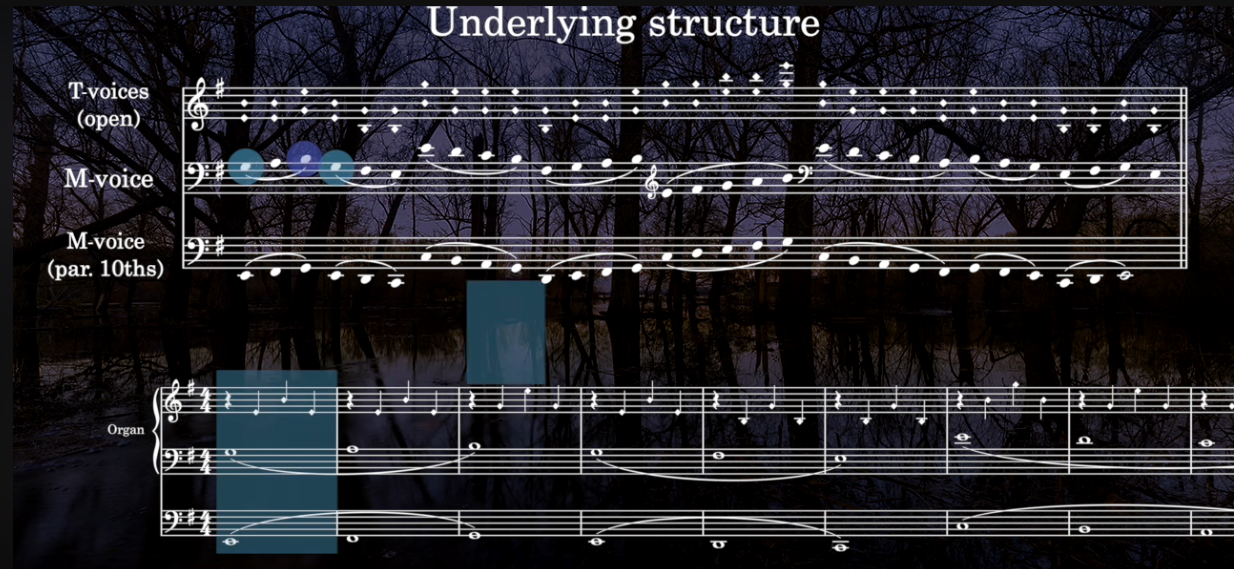

Pour comprendre la démarche, il faut revenir à la source. L'article de l'IRCAM "Computational analysis of Arvo Pärt's tintinnabuli style" (De Paiva Santana & Bresson) agit comme une pierre de Rosette. Il démontre que des œuvres bouleversantes comme Spiegel im Spiegel reposent sur une logique binaire stricte :

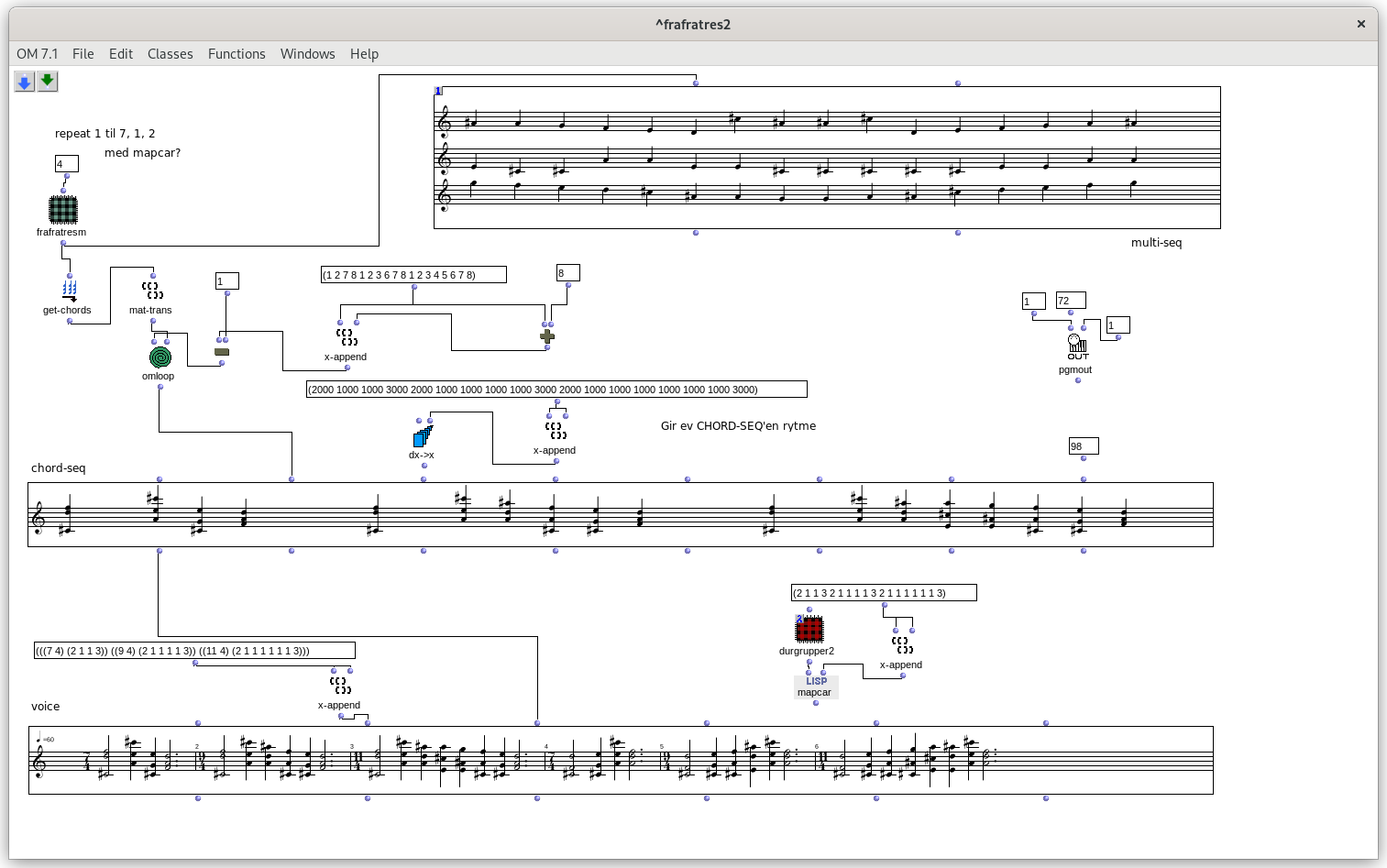

La Voix M (Mélodique) : Une voix qui avance pas à pas (diatoniquement), selon une série mathématique précise qui s'allonge à chaque cycle.

La Voix T (Tintinnabuli) : Une voix "cloche" qui gravite autour, contrainte de jouer la note de l'accord la plus proche de la voix M.

Sur le papier, c'est une formule mathématique. À l'oreille, c'est de la musique. C'est tout le paradoxe de la musique algorithmique : la rigueur structurelle mathématique engendre des émotions humaines organiques.

Le vibe-coding comme béquille :

Jusqu'à présent, pour explorer ce type de composition procédurale, il fallait maîtriser des environnements complexes comme OpenMusic. La barrière à l'entrée était fortement technique.

C'est ici que l'intelligence artificielle entre en compte pour le codeur profane que je suis. J'ai demandé à Gemini d'étudier l'analyse faite par l'IRCAM et je lui ai dis : "Aide-moi à construire un outil dans REAPER qui respecte ces règles".

Un instrument génératif dans REAPER :

Avec Gemini :

Après plusieurs allers-retours pour intégrer la gestion du temps et la théorie musicale, Gemini a abouti à un script fonctionnel. L'outil, intégré directement dans Reaper, permet de choisir la tonalité et la longueur.

Voici la musique brute générée par le script :

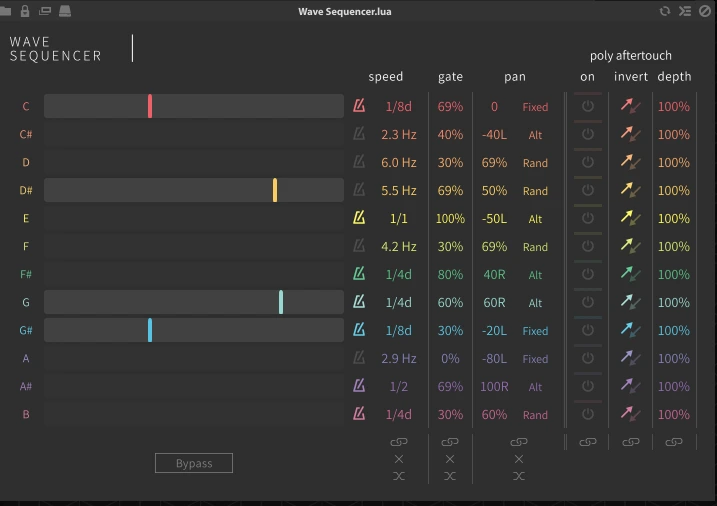

C'est intéressant, mais cela est un peu austère. Aussi j'expérimente le résultat avec Falcon d'UVI. Cet instrument virtuel permet l'utilisation de scripts très intéressants (sorte d'arpégiateurs extrêmes). J'utilise le wave sequencer qui donne a chaque note des propriétés uniques (vitesse, longueur et panoramique). Et j'utilise l'Ircam Prepared Piano 2 pour créer une atmosphère éthérée.

Voici le résultat une fois travaillé et mixé :

Avec Chat GPT :

J'ai ensuite décidé de voir ce que pourrait faire Chat GPT en lui donnant un document supplémentaire issu de la très intéressante vidéo How to compose like Arvo Pärt, tintinnabuli style de Galen DeGraf.

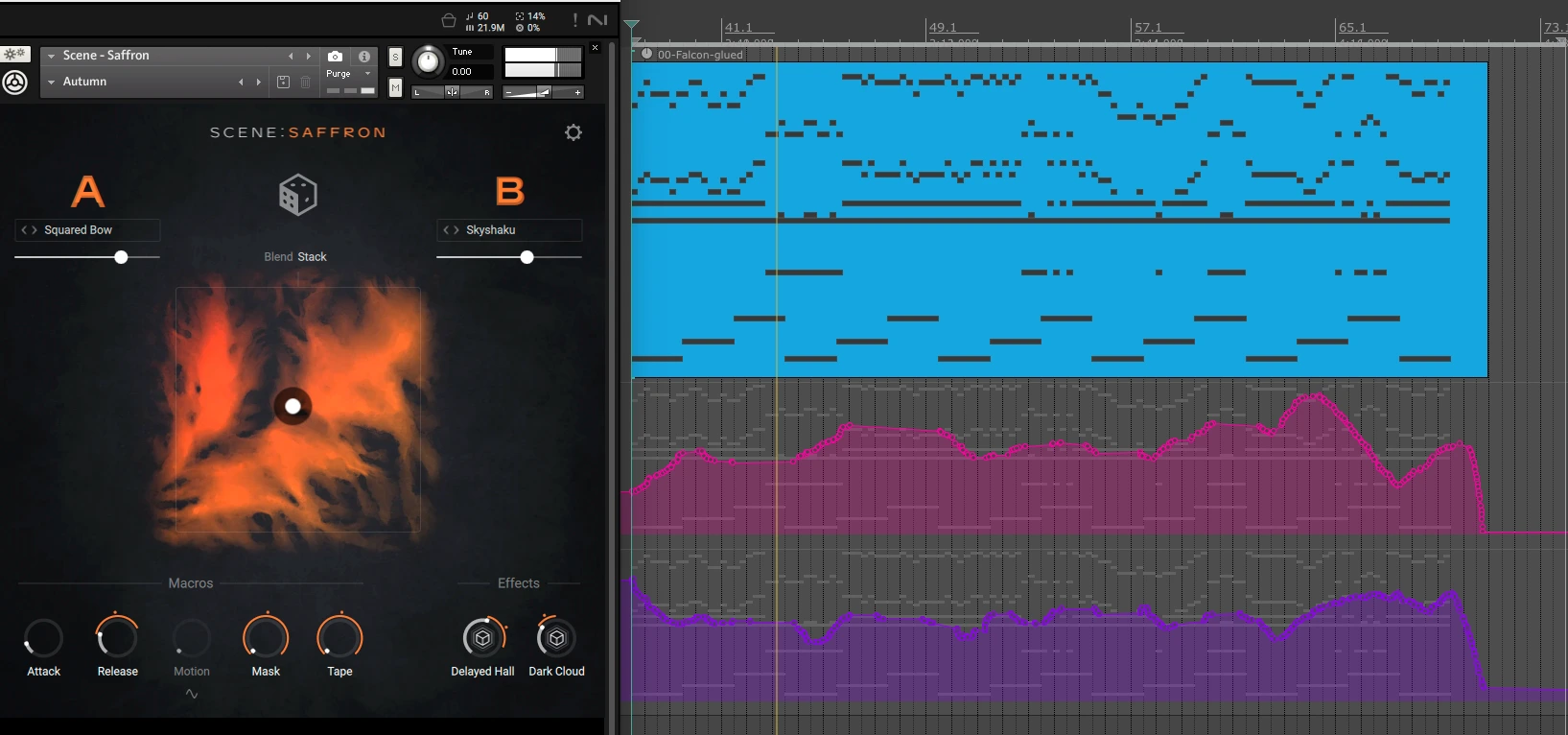

mécanique. En sortie j'ai utilisé une simple instance de Kontakt 8 Scene | Saffron avec quelques automations pour lui donner de la vie. Ainsi qu'un second instrument pour jouer la partie basse pour ajouter du corps à l'ensemble.

Le résultat :

L’illusion de la création :

Heureusement, il me reste tout de même mon expérience musicale, qui m’a appris à manipuler la matière brute et à produire avec elle. J'ai finalement agi comme je le fais avec les artistes qui arrivent au studio avec un fragment de mélodie sur un calepin. Je n'ai pas ressenti leurs émotions, ni suivi leur cursus musical ; je prends simplement ce qu'ils me donnent et je le transforme en quelque chose d'autre.

Pour exemple, voici l'un des titres issus de cette expérience, où je n'ai utilisé que des notes issues du générateur créé avec Gemini (excepté la rythmique). L'expérience a donné naissance à d'autres titres ; je les rendrai publics si l'idée vous intéresse.

Le vertige de la paternité :

Au terme de cette expérience, je me retrouve face à une question bien plus complexe que le code lui-même : quelle est la part réelle de création originale dans ce résultat ?

L’avenir de la musique assistée par IA ne se résumera peut-être pas uniquement à la génération automatique de morceaux avec SUNO et consorts. Car ces outils peuvent rendre l’informatique musicale plus accessible, plus rapide, plus expérimentale. Ils ouvrent des portes formidables pour explorer des systèmes compositionnels. Mais il nous faut être prudents, cette puissance a un prix.

Créer avec l’IA, c’est accepter une dépossession partielle :

- dépossession de la compréhension,

- dépossession du savoir-faire,

- dépossession de l’apprentissage,

- dépossession (au moins partielle) de la propriété intellectuelle.

L’enjeu n’est donc pas de savoir si l’IA va « remplacer » les compositeurs. L’enjeu est de déterminer comment rester auteur dans un processus où une partie de l’intelligence est externalisée. L’IA peut être un formidable amplificateur créatif. Elle peut surtout devenir une béquille confortable, au point de nous empêcher de marcher seuls. Tout dépendra de la posture que nous adopterons face à elle et ce n’est pas une question technologique. C’est une question de responsabilité intellectuelle et artistique. Je vous laisse avec l'excellente vidéo de Micode qui aborde brillamment la question.

L'IA ne va pas nous remplacer : elle va nous rendre idiots.